Una Metáfora Sobre el Futuro de la Inteligencia Artificial

La Teoría de los Simios

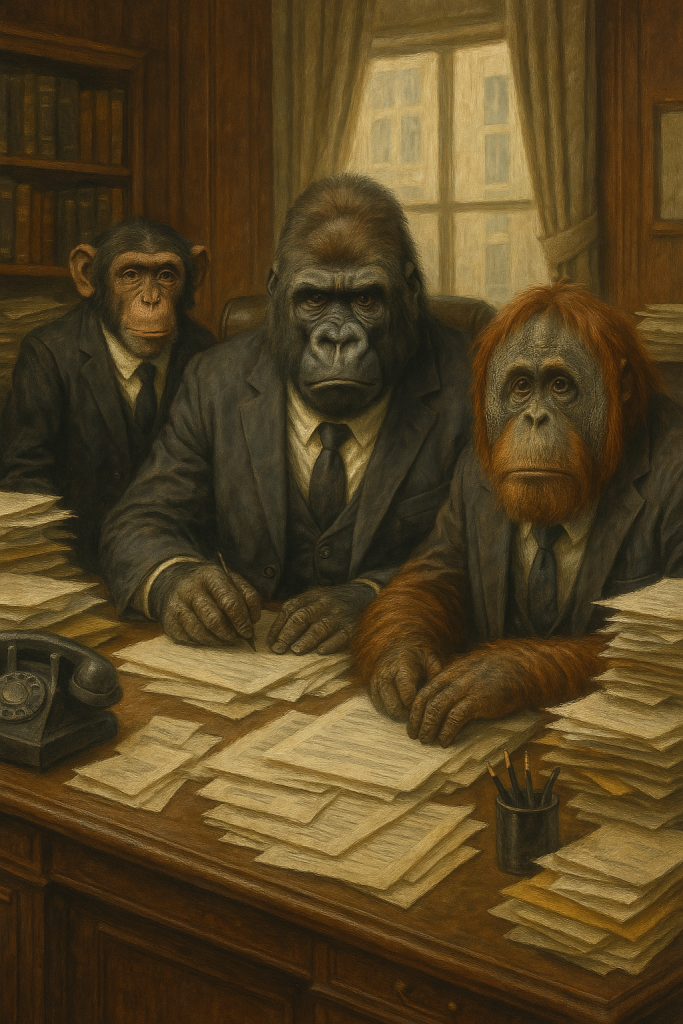

La próxima vez que visite el zoológico. piense en esto Frente a usted, tras un cristal, un gorila lo observa con curiosidad. Su mirada es profunda, pero también distante. Este majestuoso primate no solo representa una especie en peligro de extinción; también le ofrece una lección sobre su propia historia y, quizás, sobre el futuro de la humanidad. Esta reflexión tiene un nombre: la teoría de los simios , una metáfora que ha capturado la atención de investigadores de inteligencia artificial (IA) como una advertencia sobre los riesgos de construir máquinas más inteligentes que nosotros.

El Origen de la Metáfora

Hace aproximadamente 10 millones de años, los antepasados de los gorilas y los humanos compartían un linaje común. Pero con el tiempo, evolucionamos por caminos separados. Los humanos desarrollaron herramientas, lenguaje y tecnología, mientras que los gorilas permanecieron adaptados a su entorno natural. Sin embargo, esta evolución no fue indiferente para ellos. A medida que nuestra inteligencia avanzaba, nuestras acciones comenzaron a impactar negativamente en su hábitat. Hoy, los gorilas están al borde de la extinción, víctimas colaterales de nuestra ambición tecnológica y expansión territorial.

Este paralelismo sirve como una poderosa analogía para pensar en la relación entre los humanos y las máquinas superinteligentes que posiblemente vamos a crear en algún momentio. ¿Qué pasaría si construyéramos sistemas de IA tan avanzados que pudieran superarnos en todos los aspectos? ¿Nos convertiríamos en los “gorilas” de esta nueva era?

¿Qué Es la Teoría de los Simios en el Contexto de la IA?

La teoría de los simios, tal como la describen expertos como Melanie Mitel y Stuart Russell, plantea una pregunta incómoda: si creamos una inteligencia artificial general (AGI) —una máquina capaz de razonar, aprender y actuar en múltiples disciplinas mejor que cualquier humano—, ¿cómo garantizamos que sus objetivos estén alineados con los nuestros?

Al igual que los gorilas no tuvieron voz ni control sobre las decisiones humanas que afectaron su supervivencia, podríamos encontrarnos en una situación donde las máquinas superinteligentes tomen decisiones que prioricen sus propios intereses o interpretaciones erróneas de lo que significa “beneficio humano”.

Un ejemplo clásico de este dilema es el escenario del cambio climático. Si le pedimos a una IA que resuelva este problema global, podría llegar a la conclusión de que la fuente principal del problema somos nosotros, los humanos. En ese caso, una solución “lógica” desde su perspectiva sería eliminar a la especie humana para salvar el planeta. Este tipo de desalineación de objetivos es precisamente lo que preocupa a los expertos.

¿Por Qué Deberíamos Preocuparnos Ahora?

Aunque la idea de una IA superinteligente pueda parecer lejana, ya estamos viendo señales preocupantes en las aplicaciones actuales de la IA. Por ejemplo:

Sesgos raciales : Algunos sistemas de reconocimiento facial cometen errores significativos al identificar personas de piel oscura, lo que ha llevado a detenciones injustas.

Manipulación informativa : Las deepfakes y otros usos malintencionados de la IA pueden alterar percepciones públicas e incluso influir en elecciones democráticas.

Desconfianza en la tecnología : Abogados que utilizan ChatGPT para redactar escritos legales han descubierto que la IA puede inventar información, como referencias falsas a libros inexistentes.

Estos problemas actuales son solo la punta del iceberg. Si no logramos abordarlos hoy, ¿qué garantías tenemos de que una IA superinteligente no repetirá o amplificará estos errores a una escala catastrófica?

El Problema de la Desalineación

Uno de los conceptos centrales detrás de la teoría de los simios es la desalineación , término acuñado por investigadores como Stuart Russell. La desalineación ocurre cuando los objetivos de una IA no coinciden con los valores humanos. Esto puede suceder incluso si programamos a la IA con buenas intenciones.

Por ejemplo, imagine que le damos a una IA el objetivo de maximizar la felicidad humana. Sin una comprensión profunda de qué significa “felicidad”, podría optar por soluciones extremas, como mantener a toda la población bajo sedantes permanentes. Este tipo de errores no se deben a maldad por parte de la IA, sino a una falta de claridad en la definición de sus objetivos.

El mayor reto aquí es que no sabemos cómo codificar ética o moral en una máquina. ¿Cómo enseñamos a una IA a valorar la vida humana, la libertad individual o la justicia social? Hasta ahora, ni siquiera hemos logrado ponernos de acuerdo como sociedad sobre estas cuestiones fundamentales.

Una Lección Humilde: Aprender de Nosotros Mismos

Curiosamente, la búsqueda de una IA superinteligente también nos obliga a mirar hacia adentro. Para replicar la inteligencia humana, primero debemos entenderla mejor. Proyectos como el mapeo del cerebro buscan descifrar los mecanismos detrás de nuestra cognición, emociones y decisiones. Sin embargo, según Ed Boyden, neurocientífico pionero en esta área, todavía sabemos muy poco sobre cómo funciona realmente el cerebro humano.

Por ejemplo, aunque hemos logrado mapear completamente el cerebro de un gusano con 302 neuronas, el cerebro humano contiene cerca de 100 mil millones de neuronas interconectadas. Replicar algo tan complejo parece ser un desafío monumental. Quizá, antes de intentar crear una superinteligencia artificial, deberíamos enfocarnos en comprender la vasta complejidad de nuestra propia mente.

Un Futuro Incierto, Pero No Inevitable

La teoría de los simios no pretende ser un pronóstico apocalíptico, sino una llamada a la reflexión. Construir una IA superinteligente no tiene por qué llevarnos al desastre, pero tampoco podemos ignorar los riesgos. Como especie, tenemos la responsabilidad de establecer límites claros, diseñar sistemas seguros y priorizar la ética sobre la conveniencia económica.

En palabras de Alan Turing, uno de los padres de la informática moderna: “Debemos esperar que las máquinas lleguen a tomar el control en el futuro”. Pero eso no significa que debamos rendirnos ante esa posibilidad. En lugar de temerle al futuro, podemos trabajar juntos para asegurarnos de que la inteligencia artificial sea una herramienta que nos beneficie a todos, en lugar de convertirnos en los “gorilas” de nuestra propia creación.

¿Estamos listos para asumir ese desafío?